반응형

ResNet (Residual Network)

- AlexNet, VGGNet, GoogleNet 등은 layer를 깊게 쌓아 성능을 높이고자 함

- layer가 깊어질수록 학습이 어려워 지고 overfitting, Vanishing Gradient 등의 문제가 여전히 발생

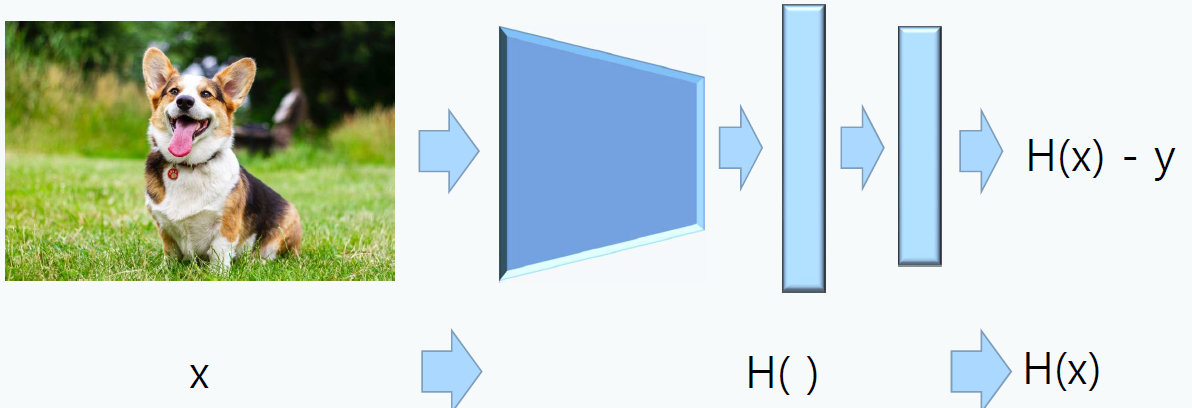

- 입력 x가 딥러닝 모델 H()를 거쳐 나온 H(x)가 정답 y (1 or 0)을 나타낼 수 있게 mapping 되도록 H() 모델을 학습

- 이미지 x를 타겟 y로 잘 mapping되는 함수 H(x)를 찾는 것이 아니라 이미지 x로 y를 바로 mapping하는 구조 고려

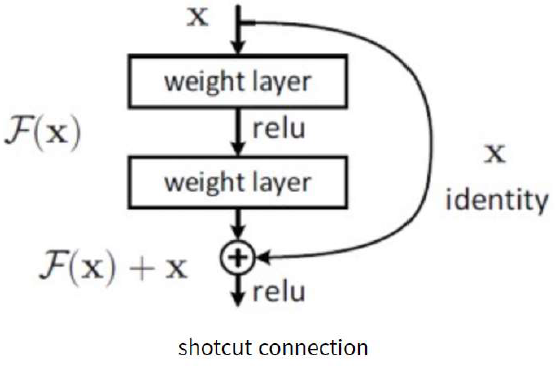

- Skip Connection 구조를 갖음

| CNN 구조 | ResNET 구조 |

| x->y로 mapping 해야 한다는 idea 최종 출력이 H(x) - x = 0 되도록 weight 학습 |

이미지에서는 H(x) = x가 되도록 학습 weight layer 출력 F(x)는 0이 되도록 학습 F(x) + x = H(x) = x가 되도록 학습 미분해도 F(x)' + 1 이므로 기울기 1은 항상 존재 모든 layer에서 기울기가 1+F(x)'이므로 기울기 소실을 막아줌 |

|

|

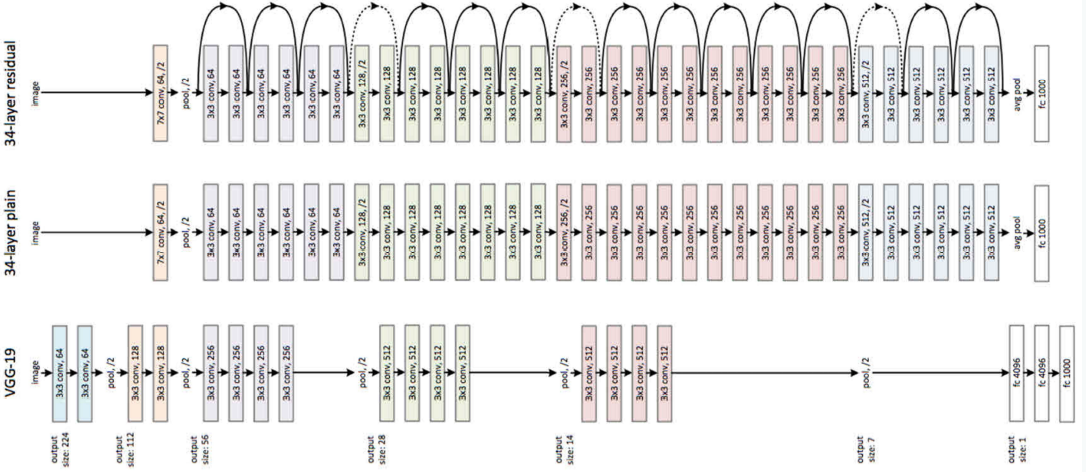

ResNet 구조

728x90

반응형

'Machine Learning > CNN' 카테고리의 다른 글

| [Machine Learning] FPN (Feature Pyramid Network) (0) | 2021.03.08 |

|---|---|

| [Machine Learning] Transfer Learning with CNNs (0) | 2021.03.05 |

| [Machine Learning] GoogleNet (Inception V4) (0) | 2021.03.05 |

| [Machine Learning] VGGNet (0) | 2021.03.05 |

| [Machine Learning] AlexNet (0) | 2021.03.05 |