반응형

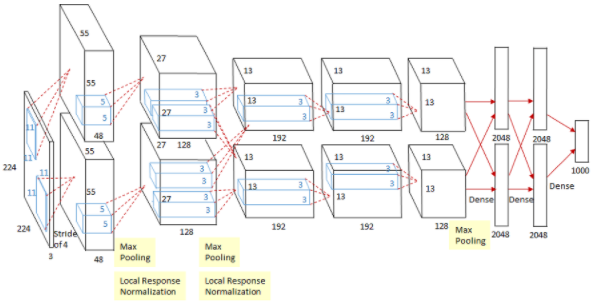

AlexNet

- 2012년 개최된 ILSVRC(ImageNet Large Scale Visual Recognition Challenge) 대회의 우승을 차지한 CNN 구조

- 논문: ImageNe Classification with Deep Convolutional Neural Networks

8개의 layer로 구성

- 5개의 convolution layer + 3개의 full-connected layer

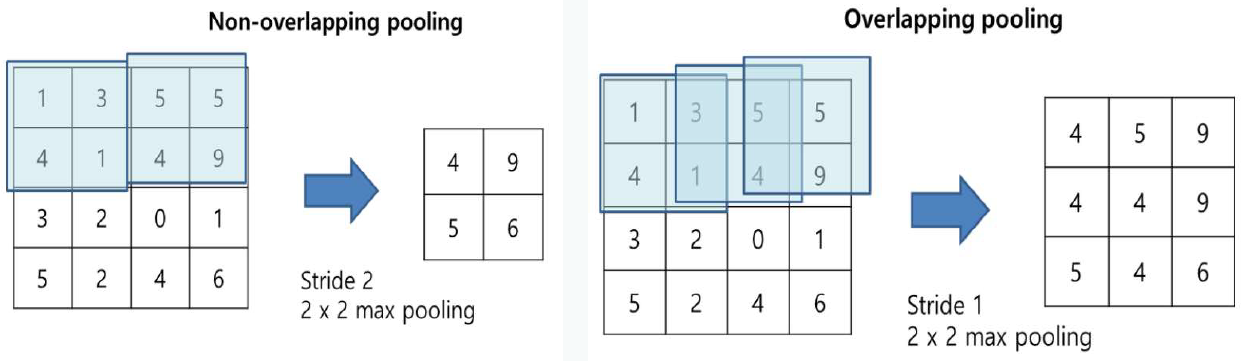

Max Pooling + Overlapping pooling 사용

- Overlapping Pooling: stirde를 커널 사이즈보다 작게

- pooling size=3, stride=2

- 최초의 max pooling 시도 → overfitting 막는데 도움을 줌

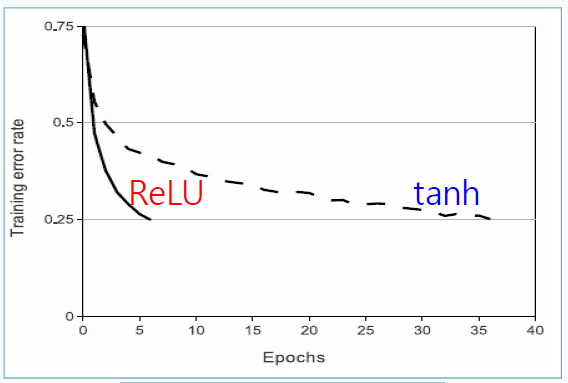

Activation Function: Relu

- Tanh 함수 대신 Relu 함수 사용

- 같은 정확도를 유지하면서 Tanh을 사용하는 것보다 6배 빠름

- Fast Convergence

Regularization 적용

- Local Response Normalization

- 인접한 kernel map n개를 모아서 정규화

- 강한 자극이 약한 자극을 막는 효과(lateral inhibition)을 모방하여 일반화에 효과적

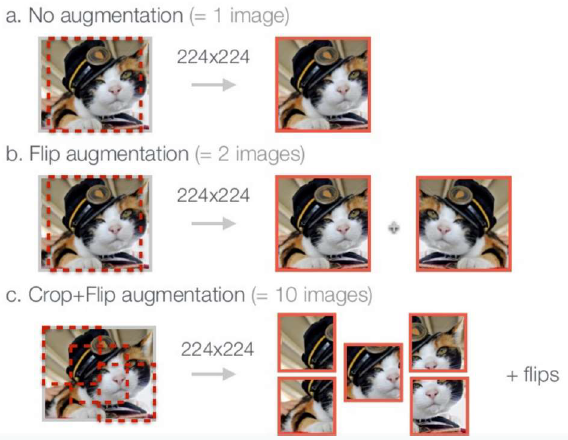

Data Augmentation

- Overfitting 방지

- RGB 픽셀에 대한 PCA를 진행하여 argumentation

- color의 변화와 출렁임에도 유지하는 object identity를 학습

- 1단계: RGB 3채널의 이미지를 R, G, B로 분리

- 2단계: 분리한 각 R,G,B 컬럼에 principal vector, principal eigenvalue에 약간의 random 요소를 더해 RGB를 미세하게 같은 방향, 크기로 변동

Inference (앙상블 적용)

- 테스트할 이미지 한장에서 이미지 4귀퉁이 + 가운데서 224x224 크기로 crop한 5장을 flip하여 10장 이미지 만듦

- 10장을 테스트(inference)한 결과를 앙상블하여 결과를 나타냄

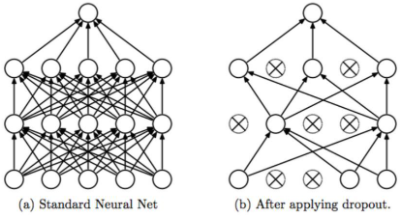

Drop Out

- Overfitting 방지

※ dropout

- fully-connected layer의 뉴런 중 일부를 생략하면서 학습을 진행하는 것

- training 시에는 적용되는 것이고, 테스트시에는 모든 뉴런을 사용

728x90

반응형

'Machine Learning > CNN' 카테고리의 다른 글

| [Machine Learning] Transfer Learning with CNNs (0) | 2021.03.05 |

|---|---|

| [Machine Learning] ResNet(Residual Network) (0) | 2021.03.05 |

| [Machine Learning] GoogleNet (Inception V4) (0) | 2021.03.05 |

| [Machine Learning] VGGNet (0) | 2021.03.05 |

| [Machine Learning] CNN(Convolutional Neural Network) (0) | 2021.03.02 |