ChatGPT (2022.11.30)

OpenAI, 20 billion parameters, Not Open Source, API Access Only

대규모 언어모델(LLM, Large Language Model)에 기반한 대화형 인공지능 서비스

ChatGPT는 텍스트 전용 모델이며 2022년 11월 Open AI에서 출시했습니다.

일반적으로 GPT-4가 더 나은 성능을 나타내지만 GPT-4가 할 수 있는 많은 텍스트 기반 기능을 수행할 수 있습니다.

ChatGPT는 InstructGPT의 형제 모델입니다.

InstructGPT 자체는 프롬프트를 수신하고 특정 지침을 따르는 자세한 응답을 제공하도록 특별히 훈련되었으며 ChatGPT는 자연어 대화에 참여하도록 설계되었습니다.

OpenAI는 더 많은 LLM 사용 사례를 잠금 해제하는 최근 발표된 ChatGPT 플러그인과 같은 업데이트 및 새로운 기능을 자주 푸시합니다.

ChatGPT에 대한 기본(non-peak) 액세스에는 구독이 필요하지 않으므로 개인 프로젝트나 실험에 적합합니다.

피크 시간에도 일반 액세스가 필요한 경우 ChatGPT 플러스 구독이 필요합니다.

GPT3.5, 1750억 개의 파라미터(매개변수)

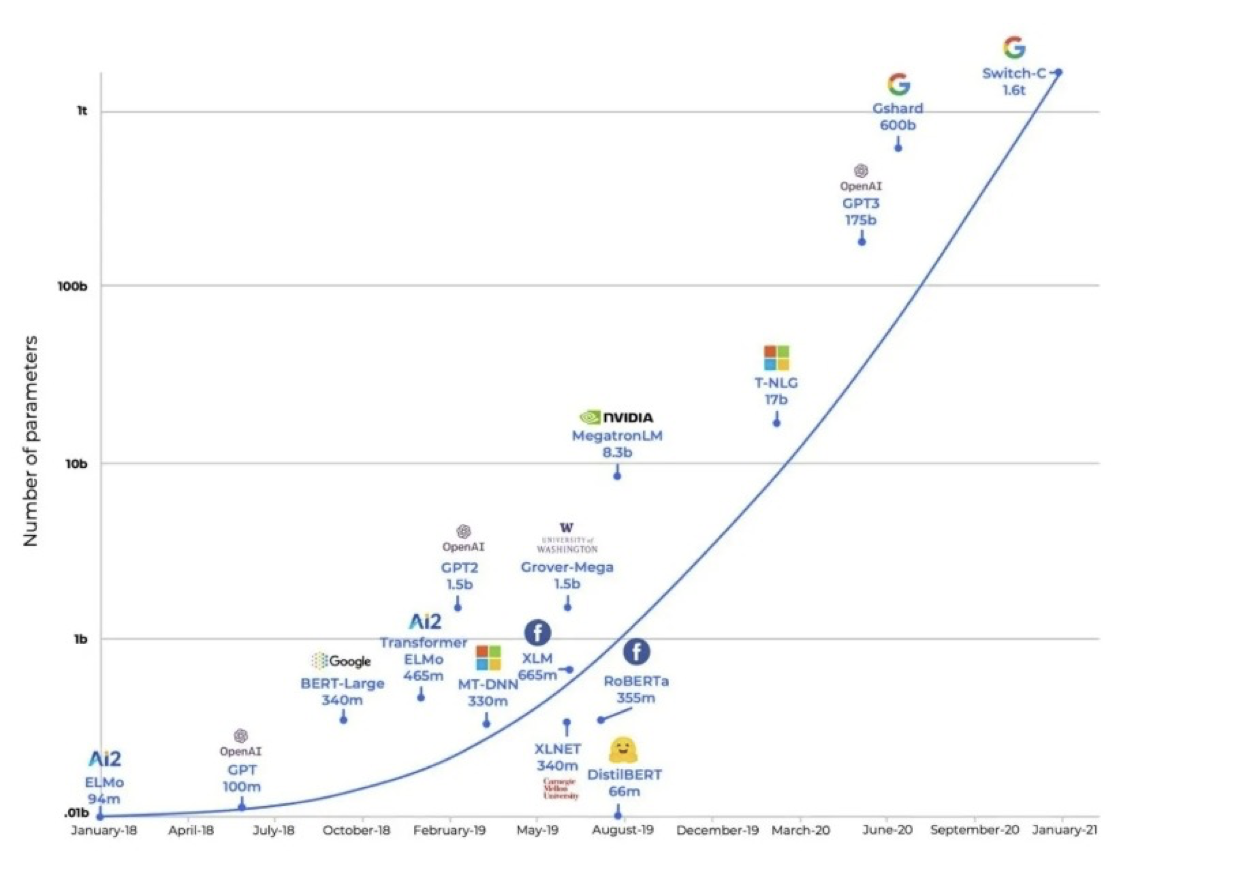

GPT-3는 ‘규모를 키우면 무엇이든 할 수 있다’는 가능성을 보여줬습니다.

In-Context Learning을 활용하여 Few-Shot Learning으로 다양한 Task에서 높은 성능을 보입니다.

그러나,

막대한 학습 비용이 듭니다.

인터넷으로 학습한 모델들은 인터넷의 크기만큼 방대한 편향을 가지고 있습니다.

온라인 상에 존재하는 수많은 가짜 정보와 편견을 그대로 학습했습니다.

학습에 사용된 예제를 외우고 패턴을 분석, 학습하는 것이지 실제로 추론해내는 것이 아닙니다.

진짜 일상 대화는 전혀 못합니다.

간단한 논리에도 약하고 상식도 없습니다.

실시간은 고사하고 최근 정보도 모릅니다.

완전히 틀린 오답을 진짜처럼 얘기합니다.

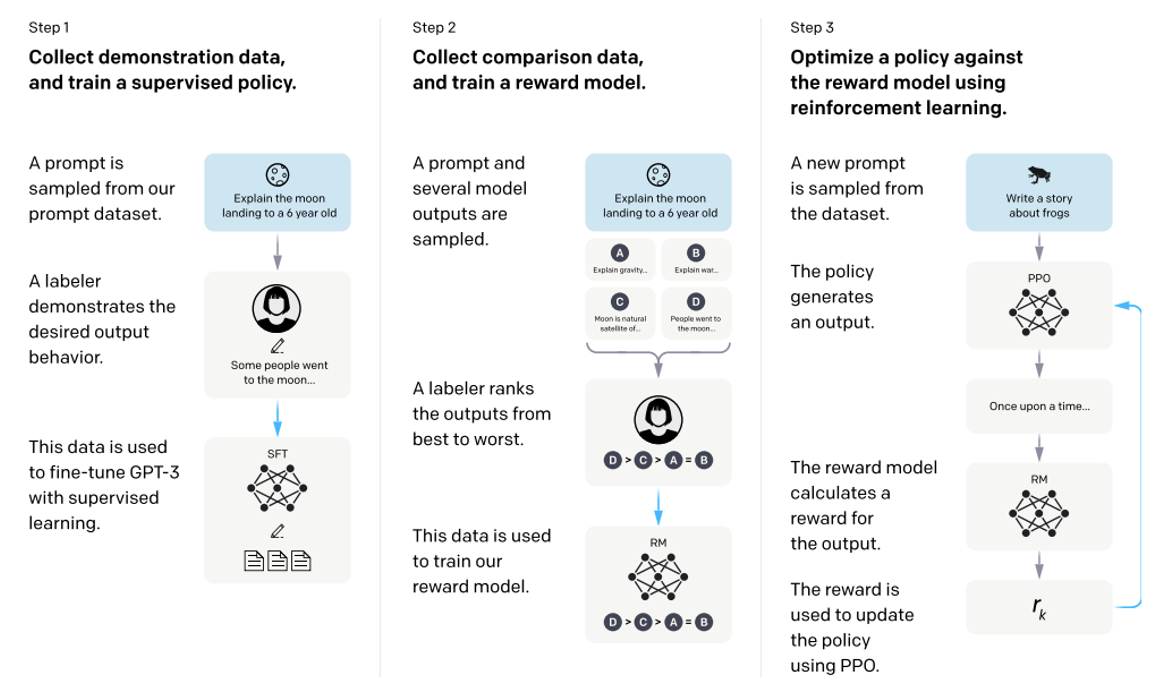

ChatGPT 학습 과정

먼저 지시문에 따라 결과를 완성하는 초기 모델을 완성한 후,

사람의 feedback을 모사하는 보상 모델(reward model)을 확보하여

이를 통해 초기 모델이 사람이 더 선호하는 결과를 추론하도록 강화학습을 진행하였습니다.

Supervised Learning의 경우, 인간 트레이너가 사용자와 ChatGPT 양쪽 모두를 연기하는 대화가 모델에 입력되었습니다.

Reinforcement Learning 단계에서는 인간 트레이너들이 먼저 모델이 이전 대화에서 만든 응답들에 순위를 매겼습니다.

한 번에 영어 기준 3,000개 정도 단어를 처리하고,

약 8,000개 단어(책 4~5페이지, 토큰 4,096)를 기억해 대화를 나눕니다.

Step 1.예제 데이터 수집 후 supervised policy를 학습 (3,000억 개 이상의 단어 입력)

=> SFT(Supervised fine-tuning) 모델 확보

인간 AI 트레이너가 사용자와 AI 어시스턴트(생성자 및 판별자)로서 양쪽 모두에 입력을 제공했습니다.

Step 2. 결과물에 대한 사람의 선호도 데이터를 학습

=> Reward Model 확보

사람이 무작위로 선택된 모델 작성 메시지를 검토하고 모델의 다양한 완성도에 순위를 매긴 다음 이를 다시 GAN에 입력하여 보상 모델을 추가로 학습시켰습니다.

Step 3. 강화학습을 사용해 Reward Model에 대해 policy를 최적화

=> InstructGPT

References

'Generative AI > Language Model' 카테고리의 다른 글

| [Large Language Model] MT-NLG (0) | 2023.07.13 |

|---|---|

| [Large Language Model] LaMDA (0) | 2023.07.13 |

| Large Language Model (LLM) (0) | 2023.07.11 |

| [Large Language Model] MPT-7B, MPT-7B-Instruct (0) | 2023.07.11 |

| [Large Language Model] GPT-NeoX-20B (0) | 2023.07.11 |