반응형

Regularization

[Machine Learning] - Neural Network의 한계

[Machine Learning] - Supervised Learning

- Neural Network의 Overfitting 방지를 위해 사용.

- 모델이 일반성을 띄게 해주는 기법: 모델의 weight들이 너무 완벽하게 overfit되지 않도록 정규화 요소를 추가

- 모델 복잡도에 대한 penalty를 부여하는 것으로 모델이 복잡해질수록 loss function이 다시 커지도록 만드는 것

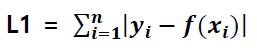

L1 Regularization (Lasso)

- Coss function 뒤에 L1항을 추가해 준 것

- Spare solution, 중요한 feature만 살림

예측 값과 정답 값의 오차를 절대값

상수텀을 빼주는 형태

작은 가중치는 0으로 수렴

L2 Regularization (Ridge)

- Coss function 뒤에 L2항을 추가해 준 것

- 영향력이 낮은 feature 유지, local noise(outlier) 영향 덜 받음

예측 값과 정답 값의 오차의 제곱 값

w가 작아지도록 학습

weight decay 효과

L1 vs L2

- L2: outlier에 대한 영향도가 상대적으로 크고 노이즈에 대해 영향도가 작다

- L1: ioutlier에 대한 영향도가 상대적으로 작고 노이즈에 대한 영향도가 크다

→ outlier가 효과적으로 적당히 무시되기를 바라면 L1을,

outlier를 주의깊게 보고 싶다면 L2를 쓰는 것이 좋을 수 있다.

728x90

반응형

'Machine Learning > Machine Learning' 카테고리의 다른 글

| [Machine Learning] Transfer Learning (0) | 2021.03.12 |

|---|---|

| [Machine Learning] ML Hyperparameter (0) | 2021.03.05 |

| [Machine Learning] Data Pre-Processing (0) | 2021.03.03 |

| [Machine Learning] One-Hot Encoding (0) | 2021.03.03 |

| Machine Learning (0) | 2021.02.27 |