728x90

반응형

GRU (Gated Recurrent Unit)

- 2014년 조경현 교수에 의해 제안

- LSTM 셀의 간소화된 버전

- LSTM Cell에서 두 상태 벡터 ct와 ht가 하나의 벡터로 합쳐짐

- 하나의 gate controller인 zt가 forget과 input gate를 모두 제어

- zt가 1을 출력하면 forget gate가 열리고 input gate가 닫힘

- zt가 0일 경우 반대로 forget gate가 닫히고 input gate가 열림

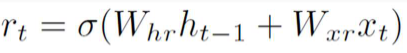

- GRU 셀은 output gate가 없어 전체 상태 벡터 ht가 타임 스텝마다 출력되며, 이전 상태 ht-1의 어느 부분이 출력될지 제어하는 새로운 gate controller인 rt가 있다.

Reset Gate

- 과거 정보를 적당히 리셋하자

- Sigmoid 함수를 출력으로 이용하여 0~1값을 이전 은닉층에 곱함

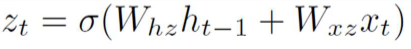

Update Gate

- 과거와 현재의 정보를 최신화 비율 결정

- Sigmoid로 출력된 결과(u)는 현시점의 정보의 양을 결정

- 1에서 뺀 값은 직전 시점의 은닉층의 정보에 곱

- 각각이 input gate와 forget gate와 유사

Candidate

- 현 시점의 정보 후보군을 계산

- 과거 은닉층의 정보를 그대로 이용하지 않고 Reset gate의 결과를 곱하여 이용

Hidden Layer

- update gate 결과와 candidate 결과를 결합하여 현 시점의 은닉층을 계산

- Sigmoid 함수 결과는 현시점 결과의 정보양 결정

- 1-Sigmoid 함수 결과는 과거 시점의 정보양 결정

728x90

반응형

'Machine Learning > RNN' 카테고리의 다른 글

| [Machine Learning] LSTM (Long Short Term Memory) (0) | 2021.03.08 |

|---|---|

| [Machine Learning] RNN(Recurrent Neural Network) (0) | 2021.03.02 |