Foundation Model

(2017) Stanford University HAI(Human-Centered Artificial Intelligence)

논문(2021): On the Opprotunities and Risks of Foundataion Models

On the Opportunities and Risks of Foundation Models

AI is undergoing a paradigm shift with the rise of models (e.g., BERT, DALL-E, GPT-3) that are trained on broad data at scale and are adaptable to a wide range of downstream tasks. We call these models foundation models to underscore their critically centr

arxiv.org

AI는 대규모의 광범위한 데이터에 대해 훈련되고 광범위한 다운스트림 작업에 적응할 수 있는 모델(예: BERT, DALL-E, GPT-3)의 등장으로 패러다임 전환을 겪고 있습니다.

우리는 이러한 모델을 Foundation Model이라고 부르며 비판적으로 중심적이지만 불완전한 특성을 강조합니다.

이 보고서는 기능(예: 언어, 비전, 로봇 공학, 추론, 인간 상호 작용) 및 기술 원칙(예: 모델 아키텍처, 교육 절차, 데이터, 시스템, 보안)에 이르기까지 Foundataion Model의 기회와 위험에 대한 철저한 설명을 제공합니다.

==> 연구자들은 트랜스포머(transformer) 모델과 대규모 언어 모델(LLM), 구축이 계속되고 있는 기타 신경망들이 일명 파운데이션 모델(foundation model)이라는 새롭고 중요한 범주를 구성한다고 분석했습니다.

Foundation Model 정의

Foundation models are models built on unlabeled data using self-supervision

레이블이 지정되지 않은 광범위한 데이터 집합에 대해 훈련된 대규모 인공 지능 모델로, 광범위한 다운스트림 작업에 적용할 수 있는 AI 모델 유형을 말합니다.

대규모 머신 러닝(ML) 모델은 방대한 양의 데이터를 대규모로 훈련(self-supervised learning, semi-supervised learning) 다양한 다운스트림 작업에 적용할 수 있는 모델을 의미합니다.

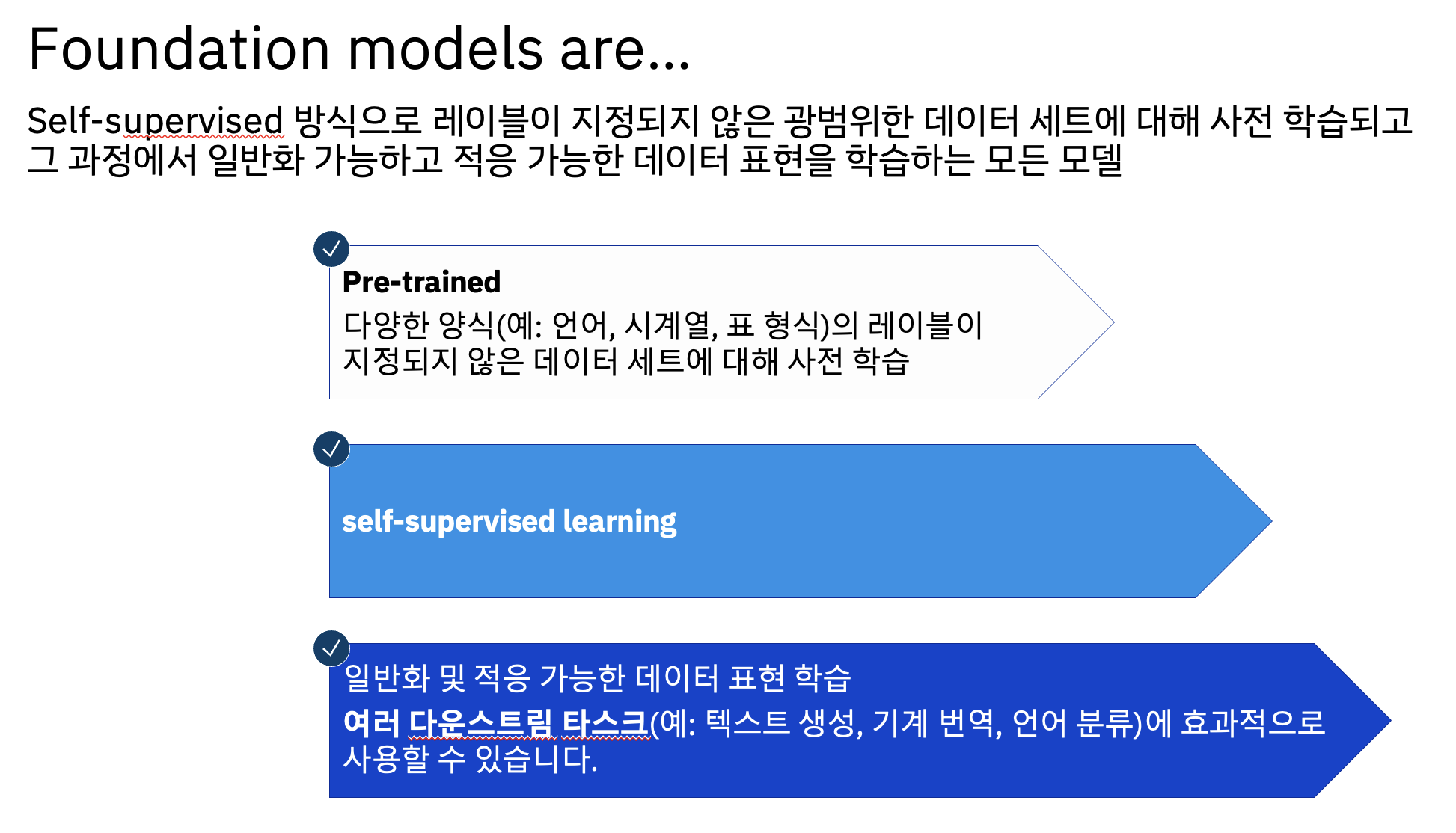

Foundation 모델은 일반적으로 self-supervised 방식으로 레이블이 지정되지 않은 광범위한 데이터 세트에 대해 사전 훈련되고 그 과정에서 일반화 가능하고 적응 가능한 데이터 표현을 학습하는 모든 모델입니다.

Foundation 모델이라는 용어는 200페이지가 넘는 스탠포드 보고서에서 만들어졌습니다. 이 보고서는 Foundation 모델이라는 새로운 종류의 모델이 등장하면서 AI가 패러다임 전환을 겪고 있는 방식을 설명합니다.

Foundation model의 초기 예는 Google의 BERT를 포함하여 사전 훈련된 대규모 언어 모델(LLM)과 특히 OpenAI의 'GPT-n' 시리즈를 포함하는 다양한 초기 GPT 기반 모델이었습니다. 이러한 광범위한 모델은 의료 코드와 같은 다양한 종류의 대상 데이터 세트를 사용하는 작업 및/또는 도메인별 모델에 차례로 사용될 수 있습니다.

텍스트 외에도 DALL-E, Flamingo, Florence 및 NOOR를 포함하여 여러 시각적 및 다중 모달 기반 모델이 제작되었습니다. 시각적 기반 모델(VFM)이 텍스트 기반 LLM과 결합되어 정교한 작업별 모델을 개발했습니다.

다양한 양식의 레이블이 지정되지 않은 데이터 세트(ex. language, time-series, tabular)에 대해 Pre-trained됨

self-supervised learning 활용

여러 다운스트림 작업(ex. 텍스트 생성, 기계 번역, 언어 분류)에서 효과적으로 사용할 수 있는 일반화(generalizable) 가능하고 적응 가능한(adaptable) 데이터 표현 학습

Enables

- Generative AI: creates new content

- Traditional AI: more rapid development and operationalization

Specific instance of

- Large Langauge Models(LLM) are Foundation Models on text or text-like things such as code

Foundation Model 2가지 특징

Emergence Behaviros (창발성, 불시에 솟아나는 특성)

이전 세대의 머신 러닝(ML) 모델은 질문(Q&A)에 답하거나 텍스트 본문을 요약하는 것과 같은 특정 동작을 수행하도록 훈련되었습니다.

그러나 Foundation 모델은 명시적으로 훈련되지 않은 작업을 수행합니다.

창발성: 하위계층(구성 요소)에는 없는 특성이나 행동이 상위계층(전체 구조)에서 자발적으로 돌연히 출현하는 현상

시스템의 행동은 직접 프로그래밍되는 것이 아니라 데이터를 통해 유추됩니다. (모든 머신러닝 모델을 포괄하고 있는 특징이기도 합니다)

신경회로망은 데이터만 있으면 알아서 확률/통계학적 모델을 구축해 다음 행동을 결정하거나 미래 예측을 할 수 있다는 점이 창발성의 기본이 됩니다.

단점

모델의 출력의 이유를 설명하기 매우 힘들다.

Homogenization (단일성)

ML 커뮤니티가 다양한 종류의 문제에 잘 작동하는 기술을 발견함에 따라 이러한 기술은 ML 시스템 구축에 대한 표준화된 접근 방식의 일부가 됩니다. Foundation Models를 사용하면 모델 자체가 균질화의 대상이 됩니다. 예를 들어 모델 자체는 도메인을 전문화하기 위해 새 모델을 개발할 수 있는 기반을 제공합니다.

하나의 거대한 Foundation 모델이 여러가지 다양한 문제를 풀게 된다는 겁니다.

BERT처럼 엄청나게 많은 양의 텍스트를 어떠한 다른 정보 없이 언어모델로 미리 학습(pre-taining)시키고, downtream을 위해 추가 학습(fine-tuninig)시키면 기존 모델의 성을 넘을 수 있는 모델을 만들 수 있게 됩니다.

많은 데이터에서의 사전 학습(pre-trained)이 언어학적 지식을 압축시킨 '단일화된' 모델을 만든다는 것을 알아낸 것입니다.

단일화 방식으로 매우 효율적인 AI 서비스 개발이 가능하다는 큰 장점을 가지고 있지만,

학습된 데이터의 한계 및 Foundation 모델은 bias(편향), hallucination(환각) 등과 같은 문제점을 가지고 있는 경우가 있습니다.

Foundation 모델의 창발적 행동을 클라이언트 사용 사례에 적용하는 것은 어려운 일입니다.

이러한 모델은 입력이 동일하더라도 다양한 콘텐츠를 생성합니다. 결과는 편향되고 부정확하며 불안정할 수 있으며 고유한 저작권 문제가 있을 수 있습니다.

적절한 안전 장치를 적용하면 모델과 해당 결과가 사용 사례에 대해 설명 가능하고 적절하며 훈련 데이터가 감사되도록 하여 생성된 콘텐츠 사용으로 인한 유해한 비즈니스 영향을 정량화하고 완화하는 기능을 용이하게 합니다.

궁극적으로 모든 모델은 AI 거버넌스 프로세스 및 정책을 사용하여 최적으로 구성되어야 합니다.

Foundation Model의 중요성

Foundation 모델은 방대한 양의 데이터에 대해 사전 교육을 받았으며 특정 작업에 맞게 fine-tuning할 수 있습니다.

Foundation 모델은 인간과 유사한 언어를 생성하고 질문에 답하는 작업을 수행하며 코드를 생성할 수도 있습니다. 그들은 인공 지능 분야에서 중대한 돌파구를 제시하며 의료, 금융 및 교육을 포함한 광범위한 산업에 혁명을 일으킬 잠재력을 가지고 있습니다.

Foundation Model Advantages

적은 양의 작업별 레이블이 지정된 훈련 데이터를 사용하여 다양한 다운스트림 작업에 대해 Foundation Model을 fine-tuning할 수 있으므로 다음과 같은 이점이 있습니다.

데이터 수집 및 라벨링을 위한 노력 감소 및 초기 비용 절감

기존의 foundation 모델을 시작점으로 사용하면 이전 접근 방식보다 레이블이 지정된 작업별 훈련 데이터가 덜 필요하므로 데이터 수집 및 레이블 지정에 대한 초기 비용이 절감됩니다.

더 빠른 배포 시간

한 번 구축하면 적은 양의 훈련 데이터를 사용하여 다운스트림 애플리케이션에 대해 동일한 foundation 모델을 fine-tuning할 수 있으므로 가치 창출 시간이 단축되고 생산성이 향상됩니다.

정확도 향상

foundation 모델은 딥 러닝의 차세대 혁명입니다. 다양한 벤치마크에서 이전 세대의 AI 모델보다 훨씬 나은 것으로 나타났습니다.

기업은 어떻게 단점을 극복하고 foundation 모델을 유리하게 활용할 수 있는가?

Foundation 모델을 처음부터 새로 만들려면 레이블이 지정되지 않은 대량의 데이터와 대규모 컴퓨팅 리소스가 필요합니다.

그러나 기업은 레이블이 훨씬 적은 데이터와 최소한의 컴퓨팅 리소스로 fine-tuning된 사전 훈련된 foundation 모델로 시작할 수 있습니다.

사전 훈련된 Foundation 모델이 존재하지 않는 경우 기업은 자체 모델을 만들고자 할 것입니다.

이것이 벅찬 것처럼 보이지만 foundation 모델을 훈련하고 검증하는 데 필요한 소프트웨어는 빠르게 발전하고 있습니다

Foundation 모델의 추론은 기존 모델보다 더 비쌉니다.

추론 비용은 모델 크기의 함수입니다. foundation 모델이 이전 모델보다 훨씬 큰 경우 더 많은 컴퓨팅 리소스가 필요합니다. 그러나 다양한 환경에 대한 foundation 모델의 크기를 관리하기 위한 도구도 있습니다.

LLM(Large Language Model)

Large Language Model is a part of Foundation Model

대규모 언어 모델은 Foundation 모델의 한 분야로, 자연어 처리에서 Foundation model은 다음과 같은 용어로도 표현됩니다.

- Large Language Model (LLM)

- Massive Language Model (MLM)

- Transformer Language Model, Transformer

초거대 AI 한계와 과제

학습 비용/시간 대비 효율성

현실 세계의 쉬운 상식 부족

- 학습하지 않으면 모른다.

모든 태스크에 뛰어나지 않을 수 있다.

- 복합연산 능력이 떨어진다.

- 학습에 주어진 데이터가 적을수록 성능이 떨어진다.

기억력이 없다

- 새로운 정보를 수용하기 어렵다.

- 새로운 값에 대해 동기화도 이뤄지지 않는다.

AI 양극화

- 초거대 AI는 자본력이 있는 빅테크 기업이 주도한다.

References

- https://hai.stanford.edu/news/what-foundation-model-explainer-non-experts

- https://hai.stanford.edu/news/reflections-foundation-models

- https://blogs.nvidia.co.kr/2023/04/04/what-are-foundation-models/

- https://research.ibm.com/blog/what-are-foundation-models

- https://en.wikipedia.org/wiki/Foundation_models

'Generative AI > Foundation Model' 카테고리의 다른 글

| Trustworthy AI(신뢰할 수 있는 AI), AI Ethics(AI 윤리) (0) | 2023.08.04 |

|---|